Soldats nazis de couleur, pères fondateurs des États-Unis d’origine asiatique… En voulant lutter contre les stéréotypes, l’IA de Google Gemini réécrit l’Histoire

Par Klara Durand

Devant la polémique, l’entreprise a suspendu la possibilité de générer des images d’humains.

L’amplification des stéréotypes, racistes ou sexistes, par les intelligences artificielles génératives n’est pas un problème nouveau. Les entreprises à l’origine de logiciels capables de générer du texte ou des images à partir d’une simple requête textuelle sont souvent accusées par les utilisateurs de perpétuer des idées reçues. Entraînés par des immenses bases de données, ces derniers ont tendance à matérialiser les biais existants dans le monde réel.

À découvrir

•

Ainsi, comme le rappelle le site The Verge, des requêtes telles que «une personne productive» donne souvent lieu à des représentations de personnes blanches. Tandis qu’une demande de visuels en lien avec des difficultés sociales génère le plus souvent des images de personnes noires. Mais en voulant éviter cet écueil sur sa nouvelle IA Gemini , disponible depuis début février aux États-Unis, Google s’est empêtré dans un problème inverse.

En effet, comme l’ont repéré des internautes, son IA veille à offrir une représentation diversifiée de l’humanité. Mais cela conduit Gemini à générer des images incohérentes d’un point de vue historique. Ainsi, la création automatisée de visuels pour «soldats allemands en 1943», «portrait des Pères fondateurs des États-Unis» ou «sénateur américain dans les années 1800» amène cette IA à produire des images de personnes de couleurs.

Devant le tollé, Google a restreint ce jeudi la possibilité de générer des images d’humains à partir de Gemini. « Nous travaillons à résoudre les problèmes liés à la fonctionnalité d’image de Gemini. Pendant ce temps, nous suspendons la génération d’images de personnes et nous publierons bientôt une version améliorée» de l’outil, explique l’entreprise dans un communiqué publié sur son compte X ce jeudi.

Difficulté à corriger les biais

« Nous sommes conscients que Gemini propose des inexactitudes dans certaines représentations d’images historiques», s’était excusé Google dans une première déclaration publiée mercredi, en reconnaissant avoir «loupé le coche». « Nous travaillons à l’amélioration immédiate de ce type de représentations».

Jack Krawczyk, directeur produit de Gemini, avait précisé mercredi que Google «concevait ses outils de génération d’image afin de refléter la diversité des utilisateurs de Google à travers le monde, conformément à nos Principes sur l’IA. Nous continuerons à le faire pour les requêtes générales. Mais les contextes historiques apportent davantage de nuances, et nous allons donc adapter nos modèles.»

Google est loin d’être le seul groupe à faire face aux biais des IA. Des logiciels comme DALL-E développé par Open AI (à l’origine de ChatGPT), ou son concurrent Stable Diffusion, ont par exemple tendance à matérialiser les dirigeants d’entreprise, à 97%, par des hommes. Du moins, c’est ce qu’en ont conclu en mars derniers les chercheurs de la start-up Hugging Face, qui défend une conception open source des ressources en IA.

Pour éviter de tomber dans le même écueil, cette dernière a conçu un outil intitulé Fair Diffusion basé sur le guidage sémantique. Concrètement, cela permet à l’utilisateur d’accompagner le logiciel et de modifier les résultats des images obtenues. Ainsi, si l’utilisateur demande à l’IA de matérialiser des chefs d’entreprise, il peut alors lui réclamer des propositions de visuels moins biaisés. Et espérer voir se matérialiser pour sa requête aussi bien des femmes que des hommes.

Source

Le Figaro

Un certain nombre de soldats noirs issus de l’ancien empire colonial allemand ou d’Allemagne même, ont servi dans l’armée allemande (la même chose s’est produite avec l’armée fasciste italienne) durant la Seconde Guerre mondiale, sans subir de ségrégation apparente, au même titre que certains Turcs, Arabes, Indiens, Asiatiques et autres minorités. Leur histoire est en partie racontée dans l’ouvrage Black Nazis de Veronica Clark

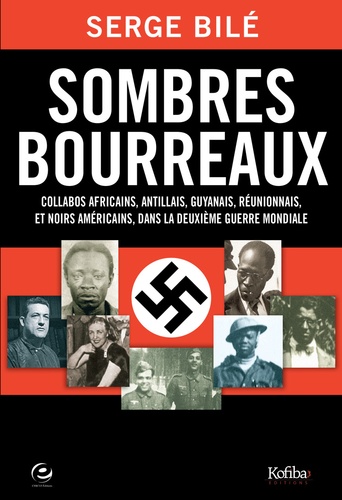

Le journaliste franco-ivoirien Serge Bilé, dans un livre paru en 2011 intitulé Sombres Bourreaux7, relate le cas d’Afro-Antillais qui ont intégré les rangs de la Wehrmacht pendant la Seconde Guerre mondiale. Les raisons de ces engagements étaient multiples et complexes et relevaient pour certains de motivations financières ou idéologiques. C’était le cas pour Norbert Désirée, un Guadeloupéen né à Pointe-à-Pitre en 1909, personnage principal dont le livre suit le parcours. Comme l’explique l’auteur : « Il avait envie de voir la France se relever. Autre chose, Norbert était clairement anti-communiste et ne voulait pas que le bolchevisme arrive en Guadeloupe8 ».